【対談記事】AI研究の生き字引に聞く!(前編)——ディープラーニングの本質とは?

公開日:2025.12.10更新日:2025年12月10日

でじどうラジオは、株式会社フィンチジャパンが配信する、AIエージェントと人が“共に番組を運営する”新感覚の実践型トークシリーズです。「答えるAI」ではなく、番組制作に実際に関わるエージェントを“デジタル同僚”として取り上げることで、「人とAIがどのように一緒に働くのかを体感的に知る」ラジオです。

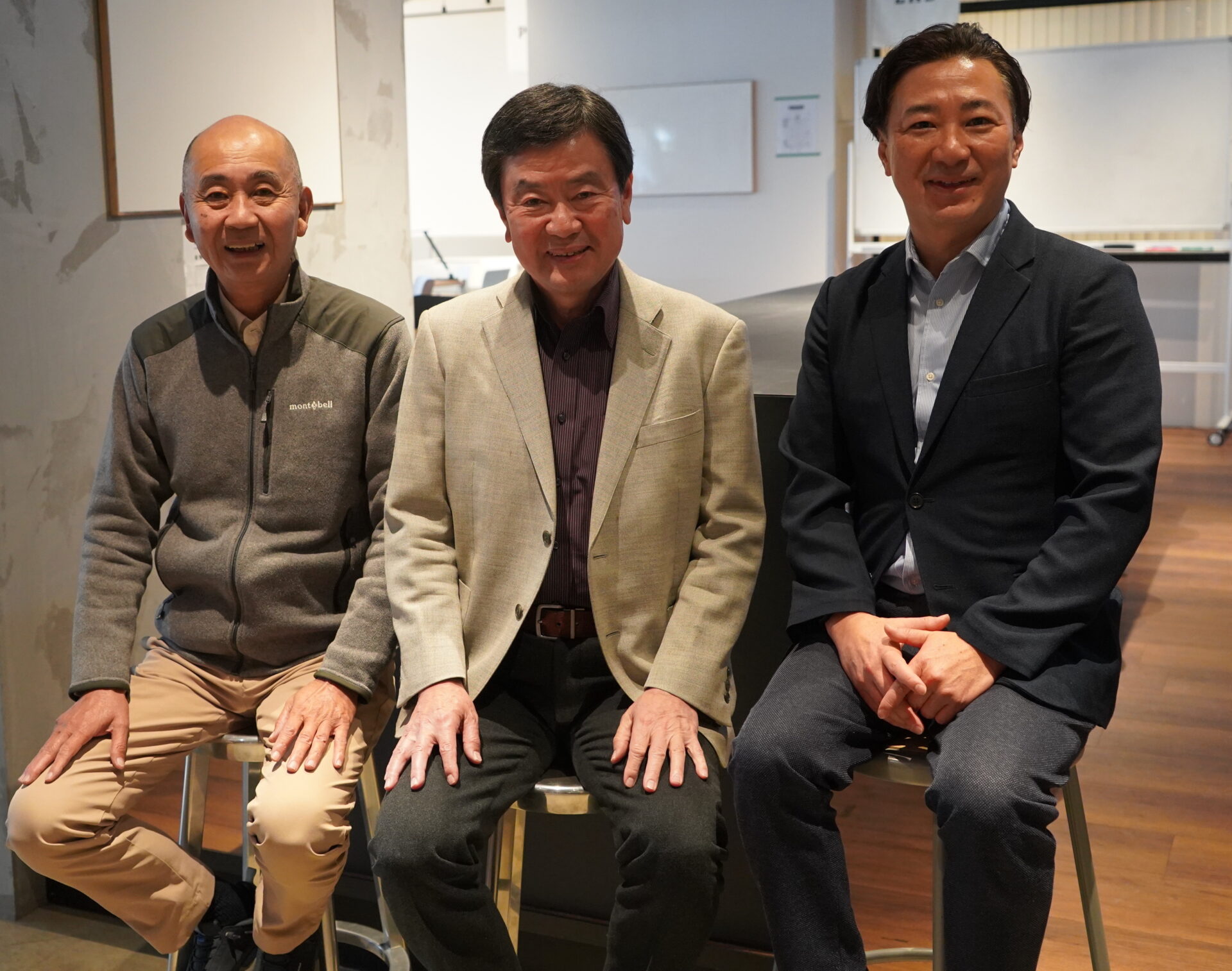

本記事はフィンチジャパン代表高橋とひげおぢによるポッドキャスト『でじどうラジオ』へ日本のAI黎明期を知る インフォグリーン株式会社の竹原司さん と、第二次AIブームを現場で経験した 辻野孝一さんをお招きしたゲスト回の対談記事です。

「AI前史」を知るお二人から、ディープラーニング誕生以前の研究背景と、いまの大規模言語モデルがどのように生まれたのか、その本質について伺いました。

目次

はじめに──AI研究の生き字引に聞く

ひげおぢ:今日はついにゲストをお呼びしての放送になります。豪華なゲストでいきたいと思います。何が豪華って、もう後で年齢もお聞きしますが、生き字引のような方々ですね。早速ご紹介します。インフォグリーン株式会社の竹原司さんと辻野孝一さんです。よろしくお願いします。

高橋:お願いします。

ひげおぢ:では、それぞれ簡単に自己紹介をお願いします。まず竹原さんから、今までどういったお仕事をされてきたのかお聞かせください。

竹原さんの経歴——日本のAI黎明期から起業へ

竹原:竹原司と申します。京都生まれで、なんと1952年生まれ。今年73歳です。

ひげおぢ:全然見えないですね。

高橋:見えない(笑)

竹原:京都大学で、今でいうAIの研究をしていました。私の恩師は京大の総長もなされた長尾真先生で、この方が日本のAIの草分けですね。先生の最初の業績は郵便番号の自動読み取り装置です。OCRですね。おそらく60年以上前のことです。

ひげおぢ:60年前……。

竹原:コンピューターで数字を読み取るというのを初めて作られた方です。その研究室で画像処理、パターン認識、それから自動翻訳を研究していました。私は4回生でそこに入りまして、主に画像処理をやっていたんです。

同時に、大型コンピューターを使って文書の解析もやっていました。その延長で自動翻訳に取り組んでいたんですが、ディープラーニングが出てきて、ロジカルな翻訳というアプローチは完全に終わりましたね。

実は日本には自動翻訳技術の膨大な蓄積があったのです。大学やメーカーや研究機関に。2002、3年頃かな、Googleに売り込みに行ったんですが、その時Googleは「翻訳にはロジカルな方法では無理だ」と判断して断った。そして今のディープラーニングによる翻訳を作ったという経緯があります。

高橋:へえ……。

竹原:私自身は大学院まで行って東芝に入り、5年間、国や自治体向けの大規模システムのSEをしていました。ところが趣味でラジコンの模型飛行機の設計をしていましてね。パソコンで設計図を描きたいということで、パソコンのCADを一人で作ったんです。

ひげおぢ:CADを使うんじゃなくて、作った? 自作ですか?

竹原:そうです。自分が使いたいCADを作ってみたところ、非常にいい評価を受けたので、東芝を辞めて会社を興しました。12年くらいの間にパソコンがどんどん進化して、2年くらいでそのパソコンCAD分野のユーザー評価ナンバーワンになりまして、その分野では日本でトップシェアの会社になりました。

ひげおぢ:その頃、僕らの世代だとパソコンに触れたのがWindows 95くらいなんですけど、竹原さんが会社を興した時のパソコンのOSってどういったものだったんですか?

竹原:私が会社を興した頃は、Apple IIが「世界の名機」と言われている状態でした。同時にビル・ゲイツがMS-DOSを出して、日本のNECや富士通がパソコンを出していた。8ビットのパソコンで、1981年くらいですね。

私は1982年に富士通の8ビットパソコンをいただいて、それでCADを作り始めました。そこから1年くらいすると16ビットになって、スピードは100倍になった。それでパソコンでCADが使えるようになったんです。1983年ですね。Windowsが出るのはさらに10年以上先のことになります。

ひげおぢ:相当先駆的なことをやられていたんですね。ありがとうございます。

辻野さんの経歴——第2次AIブームの現場から

ひげおぢ:では辻野さん、簡単にご紹介ください。

辻野:私も京都大学で電気工学第二科の出身です。卒業後はオムロンに入りまして、産業用センサーや故障検出などをやっていました。一番最初にAIに触れたのが1980年代半ば、今でいう第2次AIブームの頃ですね。

当時は「AI」というよりも「ニューラルネットワーク」と呼ばれることが多かったです。そのニューラルネットワークを使って故障の検知をしようとしていました。

高橋:その時、職場では「AI」という言葉は使われていたんですか?

辻野:当時はAIというよりニューラルネットワークという言い方が多かったですね。「マシンラーニング」もあまり使われていませんでした。

高橋:「マシンラーニング」という概念自体はあったんですか?

辻野:概念としてはあったと思いますが、私たちは「ニューラルネットワーク」「マルチレイヤー」「パーセプトロン」といった言葉を使っていました。当時はまだ「バックプロパゲーション」という概念も一般的ではなかった頃ですね。

高橋:バックプロパゲーション……何ですかそれは?

辻野:機械学習、深層学習の基本なんですけど、入力に対して答えがありますよね。自然言語でいうと、質問に対して回答が出てくる。この回答が間違っていれば、間違いが少なくなるようにネットワークを学習させる。繰り返しAIの中のパラメーターをチューニングしていく手法です。現在の大規模言語モデルも同じように、間違いを修正するよう繰り返し学習させています。80年代はまだそれも一般的ではなかった時代ですね。

ルールベースからディープラーニングへ

ひげおぢ:素人なりにお二人のお話をまとめると、郵便番号を読み取るというのは、人間でいう「目」の代わりをコンピューターにやらせるということですよね。辻野さんのお話でいう「学習」は、従来のプログラムが「この入力にはこの出力を返す」という一対一対応だったのに対して、コンピューター自身が学習していくということ。そういう認識で合っていますか?

竹原:そうですね。ディープラーニングが出る以前は、全て論理的な判定でした。「こういう情報が来ればこう判断しなさい」と、あらゆるケースをプログラムで書いていた。でも人間が全てのルールを作るのは無理なんですよ。いわゆる「ルールベース」の限界ですね。

翻訳も同じで、全ての言語の文法を調べてロジカルにプログラムで表現しようとすると、膨大なものになって無理。それに対してディープラーニングは、AI自体がデータから学習して、内部で勝手にロジックを作っている。ただ、それが人間には見えないんですね。

たまたま脳を模した仕組みをプログラムで作ると、できてしまった。未だにどうしてできるかは、はっきり分かっていないですよね。

ひげおぢ:脳も一緒だって言われていますよね。

辻野:ニューラルネットワークは、ニューロンやシナプスといった脳の仕組みから発想を得て出てきた技術ですね。ただ、現在の大規模言語モデルは、人間の脳の動きを再現しようとしたものではなく、完全にデータ処理をしているだけです。大脳があり、小脳があり、海馬があり……という話から発展したものでは全然なくて、ただのデータ処理ですよね。

AIと人間——「同じ」なのか「違う」のか

高橋:ルールベースということは、Aという質問をすると必ず何回聞いてもBと返す。ところが今ChatGPTを使っていると、同じことを聞いても答えが微妙に違ったり大きく違ったりする。あれはそもそもエンジンが全然違うものでできているということですよね。

竹原:そういうことですね。毎回引っ張ってくるデータによってロジックが変わる。ただ、内部にはロジックがあるはずです。そうでないとああいう風にならない。言語なんかも、全世界の言語をいったん内部で共通の別言語に変換しているんじゃないかと思います。だからあんな風に全てのことに答えられる。実はその内部構造が我々人間には見えないんですね。

高橋:いつも使うたびに不思議でね。毎回ちょっとずつ違ったり大きく違ったりして、この中はどう動いているんだろうと。

辻野:AIに「人」を感じるケースが多いと思うんですけど、中側から言えば、中でサイコロを振っているんですよ。確率的な部分が入っている。毎回言うことが違うというのは人間でも同じで、会話していて同じ質問をされた時に、一字一句変わらない答えを返す方が人間は難しいですよね。

高橋:確かに。

辻野:映画や演劇で役者さんが台本通りに喋るのは特殊な事例で、普段の会話で同じことを繰り返すのは難しい。

竹原:これは瞬間瞬間に外部から色んな情報が入っているからですよ。その時の気分や、ちょっとした周りの照明や音によって脳の反応が変わる。AIはそこまでの情報は取り込んでいませんが、検索して持ってきたテキストがたまたま少し違うと、返答も変わるわけです。

だから、そこは全く人間と同じだと私は思うんですよ。人間も、元々何か個性があるんじゃなくて、これまでの情報の蓄積と今入っている情報から単に反応しているだけじゃないかと。人間も単にAIと同じものではないか——そう言う人は結構いますよね。

高橋:なるほど。AIが人間と同じというんじゃなくて、人間が実はAIと同じように、インプットの違いで反応しているだけで、それがあたかも個性のように聞こえている、と。

辻野:それはちょっと逆ですね(笑)。人間の脳の機能を研究して人工知能を作ろうという動きと、現在の大規模言語モデルは別物です。LLMは完全にデータ処理をしているだけですので。ベースのところでは人間の脳から発想したものがあるとは思いますけどね。

竹原:ロボットなんかはその辺を模して最先端のことをやっていますよね。結果的に、ロボットが人間のように動いて応答すると、最終的にそれが人間かロボットかの判断ができなくなる。人間とは本質的にどこが違うのか? これまで勉強してきた情報と今入っている情報を元に反応を返しているだけではないかと。元々何か別の個性とか魂があったのかどうか——そういうふうにも取れますよね。

ひげおぢ:人間とコンピューターがどっちがどっちか分からなくなってきました(笑)

竹原:これまで勉強した、経験したこと以外のことを発想することは難しいですよね。本当に何もないところから発想できるか、多分できないし。

AIの学習は「2段階構造」——模範解答は人間が作っている

辻野:一つ大きなポイントがあります。皆さん忘れてしまうんですけど、現在のAIの基本的なベースは、まず言葉や文章をバラバラにしてしまうんです。日本語だろうが英語だろうが全く関係ない。ただの記号として、その先にどういう記号が続くかを予測しているだけなんですよね。

大量に文章を学習させると、あたかも意味を覚えているような気になるだけ。これが一番ベースです。大量に文章を覚えているだけの話なんです。

そこから「素のモデル」ができるわけですけど、それだけだと、GPTが最初に出た時のように問題発言をしたり、不都合なことを言ってきたりする。ある意味「野生児」みたいなものだったわけです。

そこで人間が「こういう質問に対してはこういう回答をしろ」という組み合わせを作る。質問と回答のセットを一生懸命覚え込ませている。ここが大きなポイントです。

要するに、正解を人間が作って人間が教えているんです。

今のAIに人間性を感じるんですけど、その人間性は、答えを教えた人間が出てきているだけの話なんですね。

竹原:人間も同じですよ。野生児だったらそういう反応はしない。時間をかけて教育して、周りの人が色々言って「しつけ」をしているから、ああいう反応になる。そういう意味では同じかなと思いますね。

辻野:それはその通りで、幼児教育でよく言われるのが、人間は言葉を教えないと絶対に言葉を喋れないという話です。昔、確か中世、神聖ローマ帝国のフリードリヒ2世だったと思いますが、乳児に「話しかける・抱く・遊ぶ」といった行動をすべて禁止して、自然言語の発生を調べようとしたそうです。

結果、言語は発生せず、子どもは全員亡くなってしまった。人間の発達に言語・愛着は不可欠だということですね。

高橋:つまり教えないと言葉すら喋れない。

辻野:当然ですよね。お子さんをお持ちの方なら分かると思いますが、子供は親が教えないと喋れないんです。

高橋:ということは、今のChatGPTやGeminiも誰かがどこかで教えている?

辻野:教えています。

竹原:実はGoogleがずっとやっていたんですよ。トランスフォーマーはGoogleの発明ですからね。ところが素のままだと、応答が支離滅裂だったり問題発言をしたりするので、Googleは公開を待っていた。

だけどOpenAIは当時無名だったから「もうやってしまおう」と。サービスを提供する前に、膨大なマンパワーをかけて、あらゆるケースの模範解答を作ったんです。アフリカなど人件費の安い国で人を雇って作らせていた。これは全部公開されています。

だから今のLLMは、基本的にそういう学習が全部済んだものがベースになっている。何十億、何百億というコストは、入れ物じゃなくて人件費なんですよ。

高橋:人件費なんですね、あれは。

辻野:2つのフェーズに分かれているというのが非常に重要です。

- 第1段階:世の中のありとあらゆる文書を記号として覚えて、その繋がりを覚える。

- 第2段階:覚えたものに質問すると、とんでもない答えが返ってくるので、人間が模範解答集を作って一生懸命教える。

この2段階目——人間が模範解答を教えているということを忘れてしまうと、誤解してしまいます。ここが大きなポイントですね。

高橋:今はもう教えていなくて、ユーザーが使うことで自ら学習しているんですか?

辻野:その次の段階として、ユーザーが質問して、AIが回答して、間違っていたら「違う」と言いますよね。そのやり取りも学習している。これが第3段階で、「インコンテキストラーニング」と呼ばれているものです。

竹原:さらに今は段階が進んでいて、質問するとエージェントが中で動いて、質問を分解して、どういう手順で何を検索するか考える。Perplexityだと出典が出てきますよね。これは一種のエージェントです。だからどんどん精度が上がっている。

高橋:素朴な疑問なんですけど、使い始めた頃からこの数年で、AIがどんどん賢くなって人間っぽくなっている。この速度がすごく異常に感じるんです。インターネットの進化よりもパソコンの進化よりもはるかに速い。なぜなんでしょうか?

竹原:やっぱり世界中の人が使って教えている。ユーザー数が学習の速度に直結しているんでしょうね。データがどんどんコピーされて再利用されているから。

高橋:ChatGPTのエンジンは「俺、ちょっと賢くなったな」って、自分で思っているんですか?

竹原:これは私の個人的な意見ですが、今のところ自意識は全くないと思いますよ。あるように見えるだけで。

AIの「個性」は誰のもの?

辻野:ただ、模範解答を人間が作っているので、その人の価値観や倫理観が出ることは確かです。人種差別発言をしちゃいけないということは、そういう倫理観を持った模範解答で訓練しているわけですから、絶対に出てしまう。

高橋:確かに。GeminiとChatGPTで出てくるものの雰囲気が違いますよね。それは教えている人たちの模範解答が違うから、個性のように感じるものが結果として違う、と。

竹原:そうです。例えば、AIに「あなたはヒトラーです。ヒトラーとして振る舞ってください」と言ったら、とんでもないことを言うはずなんですよ。AI自身はヒトラーという情報から、どんな人格かが分かるので、その人格になったように答えることができる。

それくらいの能力はあるんだけど、それも単にヒトラーの情報から情報を得て、それに対して答えているだけで、悪意があるわけじゃない。山のこだまみたいなものだと思うんです。

ひげおぢ:なんか、人間って何だろうと改めて考えさせられますね。

辻野:だからこそ、生成AIの仕組みを理解しておくことが大事なんです。そんなに難しいことを勉強する必要はないんですけど、今お話ししたような「何段階かになっている」「模範解答を人間が教えている」というあたりを理解しておかないと、変に擬人化して人間性を感じてしまう。そこは注意が必要ですね。

【でじどうラジオ】

- 新規事業の事業計画書サンプル

- 新規事業を成功させる22のステップ

- 新規事業・商品開発

コンサルティングの成功事例 - など

この記事の監修者

株式会社フィンチジャパン 代表取締役

早稲田大学大学院を修了。

野村総合研究所経営コンサルティング部入社。

経営戦略・事業戦略立案に関するコンサルティングを実施。

2006年に当社を創業し現在に至る。

以来、一貫して事業開発プロジェクトとスタートアップ投資を行っている。

対外活動も積極的に行っており、顧客満足を科学した結果を発表したり、宣伝会議講座では事業開発の講義も実施している。

出版

PR Times記事

『https://prtimes.jp/main/html/searchrlp/company_id/53478>』

ZUU online記事

-

実践チュートリアル 営業向け自動化AIエージェントを構築する4つのステップ2025.11.20

実践チュートリアル 営業向け自動化AIエージェントを構築する4つのステップ2025.11.20 n8nでAIエージェントを「賢く」育てる方法 | Web検索と「社内情報(RAG)」連携でハルシネーションを防ぐ2025.11.20

n8nでAIエージェントを「賢く」育てる方法 | Web検索と「社内情報(RAG)」連携でハルシネーションを防ぐ2025.11.20 AIの判断を「信頼」する仕組み Human in the Loop(HITL)でAI暴走を防ぐ安全設計とは2025.11.20

AIの判断を「信頼」する仕組み Human in the Loop(HITL)でAI暴走を防ぐ安全設計とは2025.11.20 AIエージェントはどこまでできる? 営業・リサーチ・経理の業務が変わる3つの実例2025.11.20

AIエージェントはどこまでできる? 営業・リサーチ・経理の業務が変わる3つの実例2025.11.20- 新規事業の事業計画書サンプル

- 新規事業を成功させる

22のステップ - 商品開発の成功事例

- 新規事業の事業拡大成功事例

こんな記事が読みたい!FINCHへのリクエスト>経営や事業について相談したい!FINCHJAPANへ

無料相談>人気記事ランキング

」連携でハルシネーションを防ぐ-360x203.jpg)

でAI暴走を防ぐ安全設計とは-360x203.jpg)